Wenn Sie in einer Agentur oder einem anderen Unternehmen den Content für eine Website kreieren oder anderweitig im Bereich der Suchmaschinenoptimierung tätig sind, dann kennen Sie es: Sie haben einen Blogbeitrag, eine Landingpage oder eine andere Unterseite erstellt und möchten nun, dass diese Seite so schnell wie möglich bei Google sichtbar ist, damit sie von Suchenden gefunden wird. In den meisten Fällen funktioniert das auch ohne Probleme, doch manchmal dauert es lange, bis eine neue Webseite in den Index aufgenommen wird. Wie Sie herausfinden, ob eine Webseite von Google indexiert wurde und wie die Beantragung der Google Indexierung ganz einfach funktioniert, erfahren Sie in diesem Beitrag.

Was ist Google Crawling und Indexierung?

Google nutzt einen sogenannten Crawler, also einen Bot, der losschickt wird, um noch nicht indexierte Seiten aufzuspüren, um diese in den Index aufzunehmen. Diesen Prozess nennt man Crawling. Der Googlebot soll also dafür sorgen, dass das große Archiv, in dem sich alle indexierbaren Webseiten befinden, immer up to date bleibt.

Woher weiß ich, ob eine Seite indexiert wurde?

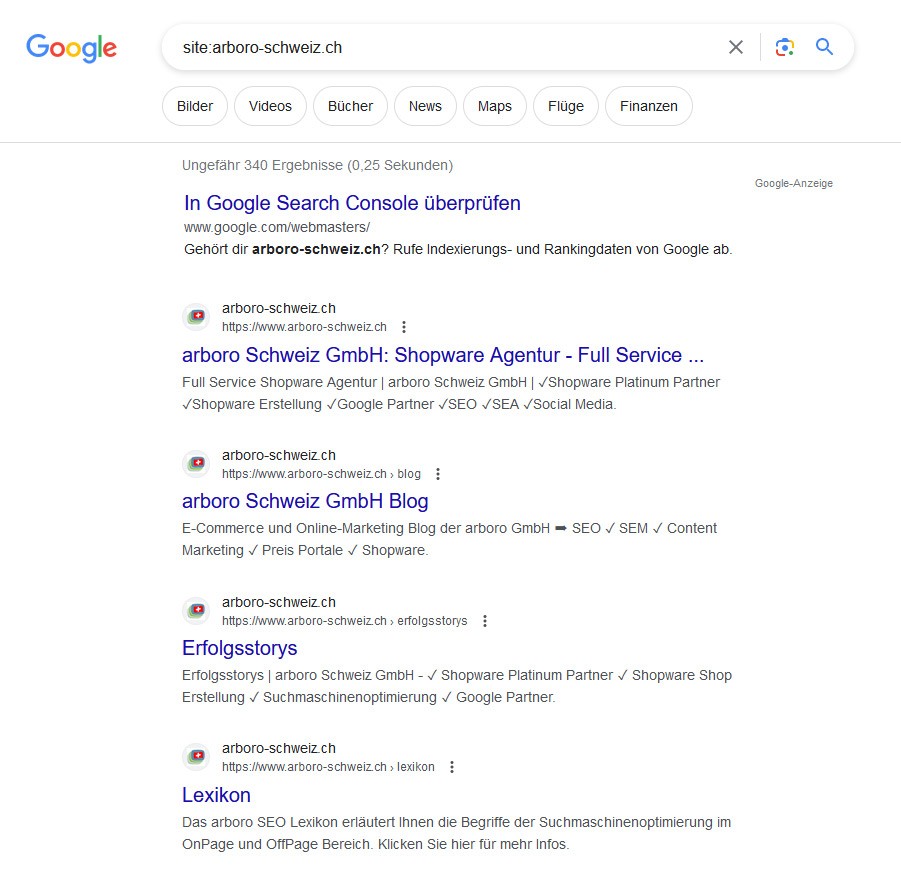

Manch einer fragt sich nun, woher man wissen soll, ob eine Webseite nun im Index ist oder nicht. Um die Anzahl der indexierten Webseiten einer Website bei Google zu sehen, kann man folgenden Befehl in die Suchleiste eingeben:

site:deinewebseite.com

Möchte man den Status der Indexierung einer einzelnen Webseite überprüfen, gibt man den folgenden Operator ein:

site:deinewebseite.com/web-page-slug

Taucht bei dieser Suche kein Ergebnis auf, ist diese nicht indexiert.

Eine andere Möglichkeit der Überprüfung bietet die Google Search Console. Über die Reiter Google Search Console > Index > Coverage kann man überprüfen, wie viele Einzelseiten einer Website in die Indexierung aufgenommen wurden. Ist die Zahl bei Null, sollte man unbedingt überprüfen, warum keine der Seiten indexiert wurden. Auch Fehlermeldungen werden hier angezeigt. Die gleiche Überprüfung kann man nicht nur mit der ganzen Website, sondern auch mit Einzelseiten durchführen. Das funktioniert über das URL Inspection Tool, das in die Search Console integriert ist.

Ältere Seite nicht indexiert? Die Problemlösung

Wurde eine bereits ältere Seite noch nicht in den Index aufgenommen, sollte man überlegen, ob eine Antragstellung etwas bringt. In manchen Fällen kann es sein, dass eine Webseite ein technisches Problem hat oder dass sie von Google als zu minderwertig angesehen wird, um in den Index aufgenommen zu werden. Mögliche Probleme und ihre Lösungen sind hier zu finden:

- Crawl-Block:

Ist nicht die gesamte Website indexiert, kann das an einem Crawlblock in der robots.txt liegen. Sind in der robots-Datei folgenden Befehle zu entdecken, sollten diese entfernt werden, denn sie sagen dem Google-Bot, dass eine Seite nicht gecrawlt werden soll:

User-agent: Googlebot

Disallow: /

User-agent: *

Disallow: /

- Noindex entfernen

Wenn man schon einmal in der robots-Datei ist, kann man auch direkt schauen, ob relevante Seiten mit dem „noindex“-Tag versehen sind. Ist das der Fall, wird diese, wie der Name bereits sagt, nicht indexiert.

- Seite in die Sitemap aufnehmen

Eine Seite sollte auch in der Sitemap sichtbar sein. Das kann man in der Search Console überprüfen. Wurde eine URL zur Überprüfung eingegeben und es steht dort „Sitemap: N/A“, dann ist sie nicht in der Sitemap enthalten.

- Unerwünschte Canonical Tags entfernen

Ein Canonical Tag sagt Google, welche die bevorzugte Version einer Webseite ist. Das kann so aussehen: <link rel=“canonical” href=“/page.html/“>.

Es kann sein, dass ein Canonical Tag falsch gesetzt wurde und somit Google eine andere Version indexiert, die allerdings nicht existiert. Die richtige Seite wird dann nicht in den Index aufgenommen.

- Orphan Pages vermeiden, intern verlinken

Orphan Pages, also verwaiste Webseiten, sind solche, auf die kein Link auf der ganzen Website führt. Dadurch kann der Googlebot diese nicht finden. Um das zu vermeiden, sollte eine gute interne Verlinkungsstrategie angewendet werden. Zumindest muss es irgendwo auf Ihrer Domain eine indexierte Seite geben, von der ein Link auf die bisher nicht indexierte Seite führt. Bei neuen Seiten sollte immer darauf geachtet werden, dass diese gut intern verlinkt werden, denn nur so können sie vom Crawler gut gefunden werden. Sinnvoll ist es, von einer mächtigen Seite auf die neue zu verlinken.

- Interne nofollow-Links bereinigen

Der Google-Crawler folgt Links, die mit einem „nofollow“-Tag ausgezeichnet sind, nicht. Links zu Seiten, die indexiert werden sollen, sollten also nicht mit diesem Tag ausgezeichnet werden. Soll eine Seite nicht indexiert werden, sollte diese besser auf noindex gesetzt oder gelöscht werden.

- Unique Content

Google nimmt Seiten auf, die es für hochwertig und sinnvoll erachtet. Wenig Inhalt, keine Einzigartigkeit, fehlende Qualität können dazu beitragen, dass eine Webseite nicht durch die Indexierung kommt.

- Crawl Budget gut nutzen

Minderwertige Seiten sollten auch deshalb vermieden werden, weil Google nur ein gewisses Crawl Budget pro Site aufwendet. Gibt es zu viele minderwertige Webseiten, zieht der Bot weiter, ohne die neuen Inhalte zu entdecken. Gehen zu viel Seiten online, ist es also durchaus üblich, dass diese nicht alle mit einem Besuch des Bots direkt alle indexiert werden.

- Hochwertige Backlinks aufbauen

Hochwertige Backlinks sorgen dafür, dass eine Seite in ihrem Ansehen steigt. Zwar indexiert Google auch Webseiten ohne Backlinks, doch solche von guter Qualität tragen insgesamt zu einem guten Ranking bei.

Einfache Schritte zur Google Indexierung

Wenn nun der Fall eingetreten ist, dass eine ältere Seite nicht in die Google Indexierung aufgenommen wurde, kann man folgende Schritte einleiten:

- Google Search Console aufrufen

- URL Inspection Tool aufrufen

- Betreffende URL ins Suchfeld kopieren

- Auf die Überprüfung warten

- Den „Indexierung beantragen“ Button drücken

Auch, wenn an einer bestehenden Webseite eine wichtige Änderung durchgeführt wurde, ist es sinnvoll, eine Indexierung zu beantragen. Etwas Geduld muss man dabei jedoch mitbringen – man stellt sich mit der Beantragung in eine virtuelle Warteschlange. Der Prozess beschleunigt sich nicht durch mehrere Antragstellungen.

Mehrere URLs zur Indexierung?

Soll nicht nur eine, sondern gleich mehrere URLs indexiert werden, dann ist es sinnvoll, eine Sitemap einzureichen. In der linken Menüleiste muss man dazu in der Search Console unter dem Punkt „Index“ einfach „Sitemaps“ auswählen und diese einreichen. Auch hier kann die Indexierung einige Zeit in Anspruch nehmen. In jedem Fall ist aber die Sitemap die bessere Entscheidung, wenn man mehrere URLs in den Index aufnehmen will, da die Search Console ein Limit einzelner Seiten pro Tag hat – mit der Sitemap umgeht man dieses Limit.

Bildquellen:

@Sughra – stock.adobe.com

arboro Schweiz GmbH Blog

arboro Schweiz GmbH Blog